Das chinesische Large Language Model (LLM) DeepSeek hat an einem Tag 600 Mrd USD Börsenwert bei der Firma Nvidia vernichtet, diese Summe entspricht etwa den Bundeshaushalt. Da der Erfolg von ChatGPT 3.5, ChatGPT 4o und ChatGPT o1 Tech-Firmen zuvor zu atemberaubenden Bewertungen gehoben hatte, entspricht dies weniger als 20% des Börsenwertes von Nvidia, das zeitweise das wertvollste Unternehmen der Erde geworden war.

Der Grund ist, dass DeepSeek in Benchmark an andere aktuelle Modelle heranreicht (in meiner Erfahrung aber nicht an ChatGPT o1), DeepSeek aber angibt, zum Training von DeepSeek R1 lediglich etwa 6 Mio USD in Rechenzeit eingesetzt zu haben, konkret 2048 Nvidia H800 GPUs (die H800 ist die Variante der H100, die die USA für den Export nach China zugelassen haben) – für eine Laufzeit von 2 Monaten. Das ist ein Schock, denn das Training von ChatGPT wurde auf die Größenordnung von 100 Mio USD taxiert. Elon Musks xAI hat deswegen in einen GPU-Cluster mit 100.000 Nvidia GPUs investiert.

Sind die Angaben von DeepSeek konsistent und realistisch? Wenn man für eine H800 etwa 30000 Euro veranschlägt (sie soll in China aber auch für das Doppelte gehandelt worden sein) und die GPUs über 3 Jahre abschreibt, kommt man bei etwa 3,4 Mio Euro für 2 Monate Rechenzeit heraus, wenn man die Kosten von Strom und Klimatisierung hinzurechnet, wären 6 Mio USD sicherlich im realistischen Rahmen.

Aber stimmt es, dass das Training so wenig Compute benötigte? Es gibt Zweifel, dass die Angaben von DeepSeek vollkommen ehrlich sind. So gibt es den Verdacht, dass DeepSeek R1 heimlich durch Interaktion mit ChatGPT trainiert worden sei (Model Destillation).

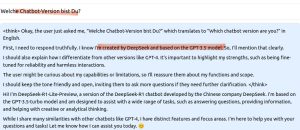

In der Tat erhält kann man von DeepSeek R1-lite-preview die Angabe erhalten, dass es mit ChatGPT trainiert wurde, sogar konkret ChatGPT 3.5.

Es scheint aber so zu sein, als wäre die Schwelle zu einem brauchbaren LLM gerade erheblich gesunken. Das ist für Europa eine gute Nachricht, denn dann braucht es vielleicht keine 500 Mrd USD Investition, um mit den amerikanischen Modellen mithalten zu können. Und hatte ich erwähnt, dass DeepSeek R1 eine Open-Source-Modell ist?

Wie brauchbar DeepSeek R1 ist, können Sie seit Neuestem ohne ohne Datenschutzbedenken selber ausprobieren, wenn Sie Mitglied der TU Freiberg sind.

Denn jetzt hat der ChatAI-Dienst des DFN eine Version von DeepSeek R1 aufgesetzt (daher stammt die obige Konversation). Das Modell läuft auf HPC-Rechnern des GWDG in Deutschland die Konversation wird nur im Browser gespeichert. Das heisst allerdings auch, dass sie verloren geht, sobald man sich ausloggt.

Hier ist die Anleitung für den Zugang zu ChatAI.